转摘【深度学习】模型训练教程之Focal Loss调参和Dice实现

榆木稚年阅读量 432

prism language-css

文章目录

1 Focal Loss调参概述

2 实验

3 FocalLoss 对样本不平衡的权重调节和减低损失值

4 多分类 focal loss 以及 dice loss 的pytorch以及keras/tf实现

4.1 pytorch 下的多分类 focal loss 以及 dice loss实现

4.2 keras/tf 下的多分类 focal loss 以及 dice loss实现1 Focal Loss调参概述

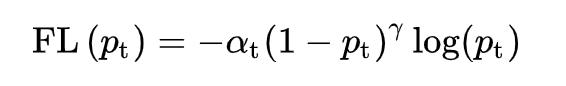

有两个参数可调, alpha和gamma.

alpha是控制类别不平衡的.

gamma是控制难易样本的.

一般都是调alpha, gamma自己没调过,有大佬调过的可以发表一下见解.

alpha越大,recall会越高,precision会越低.

当alpha增大时,比如说增大到1, 以一个检测的二分类为背景, 这时候focal loss就不会包含负样本的loss了, 想要focal loss最小我只要全预测为正即可, 这时候自然recall就会100%, precision也会降低.

当alpha减小,比如减小到0, 这时候focal loss中只有负样本的loss, 那只要网络对所有样本

===========================

【来源: CSDN】

【作者: 李响Superb】

【原文链接】 https://lixiang.blog.csdn.net/article/details/118753413

声明:转载此文是出于传递更多信息之目的。若有来源标注错误或侵犯了您的合法权益,请作者持权属证明与本网联系,我们将及时更正、删除,谢谢。标签:

0/300

全部评论0